破解深度学习基础篇 模型算法与实现 深度学习教程机器学习大模型算法应用与开发人工智能chatgpt书籍

¥82.40

| 运费: | ¥ 0.00-20.00 |

商品详情

书名:破解深度学习(基础篇):模型算法与实现

定价:109.8

ISBN:9787115646194

作者:瞿炜

版次:第1版

出版时间:2024-10

内容提要:

本书旨在采用一种符合读者认知角度且能提升其学习效率的方式来讲解深度学习背后的基础知识。 本书总计9章,深入浅出地介绍了深度学习的理论与算法基础,从理论到实战*展开。前三章旨在帮助读者快速入门,介绍了*要的数学概念和*工具的用法。后六章沿着深度学习的发展脉络,从*简单的多层感知机开始,讲解了深度神经网络的基本原理、常见挑战、优化算法,以及三大典型模型(基础卷积神经网络、基础循环神经网络和注意力神经网络)。 本书系统*,深入浅出,且辅以生活中的案例进行类比,以此降低学习难度,帮助读者迅速掌握深度学习的基础知识。本书适合有志于投身人工智能领域的人员阅读,也适合作为高等院校人工智能专业的教学用书。

作者简介:

瞿炜,美国伊利诺伊大学人工智能博士,哈佛大学、京*大学客座教授;前中国科学院大学教授、模式识别国家重点实验室客座研究员;国家部委特聘*、重点实验室学术委员会委员;知名国际期刊编委,多个*学术期刊审稿人及国际学术会议委员。 李力,人工智能*,长期致力于计算机视觉和强化学习领域的研究与实践。曾在多家*科技企业担任*算法工程师,拥有十余年行业经验,具备丰富的技术能力和深厚的理论知识。 杨洁,人工智能和自然语言处理领域*应用*,在自然语言理解、基于知识的智能服务、跨模态语言智能、智能问答系统等技术领域具有深厚的实战背景。

目录:

第 1章 欢迎来到深度学习的世界 1

1.1 什么是深度学习 1

1.2 主要核心模型 3

1.2.1 卷积神经网络 3

1.2.2 循环神经网络 4

1.2.3 注意力机制 4

1.2.4 深度生成模型 5

1.2.5 小结 6

1.3 研究和应用领域 6

1.3.1 计算机视觉 6

1.3.2 语音技术 7

1.3.3 自然语言处理 7

1.3.4 多模态融合 8

1.3.5 小结 9

1.4 使用的技术栈 9

1.4.1 编程语言 9

1.4.2 深度学习框架 9

1.4.3 数据集 10

1.4.4 代码编辑器 10

1.4.5 项目IDE 10

1.4.6 小结 10

第 2章 *要的数学预备知识 11

2.1 线性代数 12

2.1.1 学人工智能为什么要学线性

代数 12

2.1.2 线性代数名字的由来 13

2.1.3 线性代数的本质作用 13

2.1.4 学线性代数为何总强调几何

意义 13

2.1.5 标量 14

2.1.6 向量 14

2.1.7 矩阵 17

2.1.8 张量 19

2.1.9 小结 20

2.2 微积分 20

2.2.1 极限 21

2.2.2 导数 21

2.2.3 微分 23

2.2.4 偏导数 23

2.2.5 梯度 24

2.2.6 链式法则 24

2.2.7 小结 25

2.3 概率统计 25

2.3.1 什么是概率 25

2.3.2 概率和统计 28

2.3.3 贝叶斯定理 30

2.3.4 *似然估计 31

2.3.5 小结 31

第3章 环境安装和工具使用 33

3.1 配置深度学习环境 34

3.1.1 CUDA简介 34

3.1.2 显卡驱动 34

3.1.3 安装CUDA 35

3.1.4 安装Anaconda 37

3.1.5 小结 39

3.2 conda实用命令 39

3.2.1 Anaconda 图形化界面介绍 39

3.2.2 conda的命令行操作 41

3.2.3 小结 43

3.3 Jupyter Notebook快速上手 44

3.3.1 Jupyter Notebook的安装与

运行 45

3.3.2 常用配置项 47

3.3.3 快捷键 48

3.3.4 Markdown语法 49

3.3.5 小结 50

3.4 安装深度学习框架PyTorch 50

3.4.1 PyTorch、CUDA与

NVIDIA 50

3.4.2 安装PyTorch 50

3.4.3 验证安装是否成功 51

3.4.4 小结 52

第4章 深度神经网络:误差倒查

分解 53

4.1 神经网络原理 53

4.1.1 神经元模型 53

4.1.2 神经网络结构 54

4.1.3 损失函数 57

4.1.4 反向传播 58

4.1.5 小结 59

4.2 多层感知机 59

4.2.1 线性模型的局限 60

4.2.2 多层感知机模型 61

4.2.3 *函数 61

4.2.4 小结 66

4.3 前向传播和反向传播 67

4.3.1 前向传播 67

4.3.2 反向传播 68

4.3.3 小结 70

4.4 多层感知机代码实现 70

4.4.1 搭建神经网络的步骤 71

4.4.2 代码实现 71

4.4.3 小结 76

4.5 回归问题 76

4.5.1 一元线性回归 77

4.5.2 多元线性回归 78

4.5.3 多项式回归 79

4.5.4 简单理解梯度下降 80

4.5.5 代码实现 80

4.5.6 小结 84

4.6 分类问题 84

4.6.1 多分类问题的数学表示 85

4.6.2 Softmax回归 86

4.6.3 对数损失函数 86

4.6.4 交叉熵损失函数 87

4.6.5 代码实现 87

4.6.6 小结 90

第5章 常见挑战及对策:一切为了

泛化能力 91

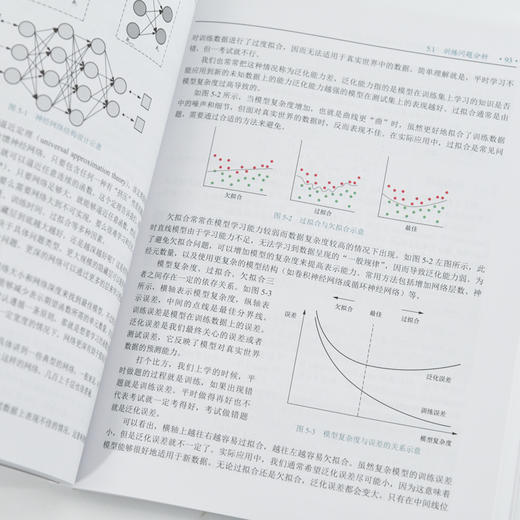

5.1 训练问题分析 91

5.1.1 模型架构设计 91

5.1.2 过拟合与欠拟合 92

5.1.3 代码实现 94

5.1.4 小结 99

5.2 过拟合欠拟合应对策略 99

5.2.1 数据集选择 99

5.2.2 模型选择 100

5.2.3 训练策略选择 101

5.2.4 小结 102

5.3 正则化 102

5.3.1 正则化定义 103

5.3.2 L1正则化 103

5.3.3 L2正则化 104

5.3.4 范数惩罚 105

5.3.5 权重衰减 105

5.3.6 小结 106

5.4 Dropout方法及代码实现 106

5.4.1 基本原理 106

5.4.2 直观解释 107

5.4.3 优缺点分析 109

5.4.4 代码实现 109

5.4.5 小结 112

5.5 梯度消失和梯度爆炸 112

5.5.1 根源分析 113

5.5.2 梯度消失 114

5.5.3 梯度爆炸 114

5.5.4 解决办法 115

5.5.5 小结 117

5.6 模型文件的读写 117

5.6.1 张量的保存和加载 117

5.6.2 模型参数的保存和加载 118

5.6.3 小结 119

第6章 梯度下降算法及变体:*

求解模型参数 120

6.1 为什么要学*化 120

6.1.1 深度学习的*化 120

6.1.2 训练误差和泛化误差 121

6.1.3 常见的优化挑战 123

6.1.4 小结 125

6.2 损失函数及其性质 126

6.2.1 起源和重要性 126

6.2.2 *似然估计 126

6.2.3 *后验 128

6.2.4 贝叶斯估计 129

6.2.5 损失函数的性质 129

6.2.6 小结 133

6.3 梯度下降算法 133

6.3.1 搜索逼近策略 134

6.3.2 梯度 134

6.3.3 偏导数链式法则 135

6.3.4 学习率 136

6.3.5 梯度下降算法 136

6.3.6 小结 137

6.4 梯度下降算法的各种变体 137

6.4.1 加速版改进:随机梯度

下降法 138

6.4.2 折中版改进:小批量随机梯度

下降法 139

6.4.3 一阶动量改进版:动量法 140

6.4.4 二阶动量改进版:AdaGrad

算法 142

6.4.5 自动调整学习率:RMSProp和

AdaDelta算法 144

6.4.6 自适应动量:Adam算法 145

6.4.7 算法大串联及讨论 145

6.4.8 小结 147

6.5 梯度下降算法代码实现 147

6.5.1 梯度下降过程 147

6.5.2 不同优化器效果对比 151

6.5.3 小结 155

6.6 学习率调节器 155

6.6.1 简介 155

6.6.2 常见的学习率调节器 156

6.6.3 代码实现 157

6.6.4 模型训练对比 158

6.6.5 常见学习率调节器的实现 160

6.6.6 小结 161

第7章 基础卷积神经网络:图像处理

利器 162

7.1 为什么要用卷积神经网络 162

7.1.1 全连接层的问题 162

7.1.2 多层感知机的局限 163

7.1.3 解决思路 164

7.1.4 小结 164

7.2 图像卷积 165

7.2.1 卷积 165

7.2.2 图像卷积 166

7.2.3 互相关运算 167

7.2.4 小结 168

7.3 卷积层 168

7.3.1 网络结构 169

7.3.2 感受野 169

7.3.3 与全连接层的区别 170

7.3.4 小结 172

7.4 卷积层常见操作 172

7.4.1 填充 172

7.4.2 步长 173

7.4.3 卷积常见参数关系 173

7.4.4 多通道卷积 174

7.4.5 分组卷积 175

7.4.6 小结 176

7.5 池化层 176

7.5.1 卷积神经网络典型结构 177

7.5.2 *池化和平均池化 177

7.5.3 池化层特点 178

7.5.4 小结 179

7.6 卷积神经网络代码实现 179

7.6.1 LeNet简介 179

7.6.2 代码实现 180

7.6.3 模型训练 182

7.6.4 小结 184

第8章 基础循环神经网络:为序列

数据而生 185

8.1 序列建模 185

8.1.1 序列数据 185

8.1.2 序列模型 187

8.1.3 小结 188

8.2 文本数据预处理 189

8.2.1 预处理流程 189

8.2.2 去除噪声 189

8.2.3 分词 190

8.2.4 去除停用词 190

8.2.5 标准化 191

8.2.6 词表 191

8.2.7 特征提取 191

8.2.8 小结 193

8.3 循环神经网络 194

8.3.1 核心思想 194

8.3.2 展开计算图 194

8.3.3 RNN结构 195

8.3.4 训练模式 196

8.3.5 小结 197

8.4 RNN的反向传播 197

8.4.1 沿时间反向传播 197

8.4.2 参数梯度 198

8.4.3 小结 199

8.5 时间序列数据预测 199

8.5.1 数据集准备 200

8.5.2 构建模型 202

8.5.3 小结 207

8.6 编解码器思想及Seq2Seq模型 208

8.6.1 编解码器思想 208

8.6.2 序列到序列学习 209

8.6.3 编码器 210

8.6.4 解码器 210

8.6.5 模型训练 211

8.6.6 束搜索算法 211

8.6.7 小结 214

8.7 Seq2Seq模型代码实现 214

8.7.1 模型架构 214

8.7.2 Seq2Seq模型简单实现 215

8.7.3 小结 222

第9章 注意力神经网络:赋予模型

认知能力 223

9.1 注意力机制的原理 224

9.1.1 生物学中的注意力 224

9.1.2 深度学习中的注意力机制 225

9.1.3 编解码器思想和注意力机制的

结合 225

9.1.4 注意力的计算 228

9.1.5 全局注意力、局部注意力和

自注意力 230

9.1.6 注意力机制与Transformer 231

9.1.7 注意力机制的应用 231

9.1.8 小结 232

9.2 复杂注意力机制 233

9.2.1 *注意力机制计算的

局限性 233

9.2.2 键值对注意力 234

9.2.3 多头注意力 235

9.2.4 自注意力 236

9.2.5 小结 238

9.3 注意力池化及代码实现 239

9.3.1 注意力可视化 239

9.3.2 注意力池化 241

9.3.3 小结 246

9.4 Transformer模型 246

9.4.1 模型结构 246

9.4.2 编码器结构 247

9.4.3 多头自注意力层 248

9.4.4 位置嵌入 249

9.4.5 残差结构 250

9.4.6 解码器 251

9.4.7 编解码器的协同工作 252

9.4.8 线性层和Softmax层 253

9.4.9 优缺点 254

9.4.10 小结 254

9.5 Transformer模型的代码实现 255

9.5.1 任务数据 255

9.5.2 Transformer模型 256

9.5.3 小结 264

定价:109.8

ISBN:9787115646194

作者:瞿炜

版次:第1版

出版时间:2024-10

内容提要:

本书旨在采用一种符合读者认知角度且能提升其学习效率的方式来讲解深度学习背后的基础知识。 本书总计9章,深入浅出地介绍了深度学习的理论与算法基础,从理论到实战*展开。前三章旨在帮助读者快速入门,介绍了*要的数学概念和*工具的用法。后六章沿着深度学习的发展脉络,从*简单的多层感知机开始,讲解了深度神经网络的基本原理、常见挑战、优化算法,以及三大典型模型(基础卷积神经网络、基础循环神经网络和注意力神经网络)。 本书系统*,深入浅出,且辅以生活中的案例进行类比,以此降低学习难度,帮助读者迅速掌握深度学习的基础知识。本书适合有志于投身人工智能领域的人员阅读,也适合作为高等院校人工智能专业的教学用书。

作者简介:

瞿炜,美国伊利诺伊大学人工智能博士,哈佛大学、京*大学客座教授;前中国科学院大学教授、模式识别国家重点实验室客座研究员;国家部委特聘*、重点实验室学术委员会委员;知名国际期刊编委,多个*学术期刊审稿人及国际学术会议委员。 李力,人工智能*,长期致力于计算机视觉和强化学习领域的研究与实践。曾在多家*科技企业担任*算法工程师,拥有十余年行业经验,具备丰富的技术能力和深厚的理论知识。 杨洁,人工智能和自然语言处理领域*应用*,在自然语言理解、基于知识的智能服务、跨模态语言智能、智能问答系统等技术领域具有深厚的实战背景。

目录:

第 1章 欢迎来到深度学习的世界 1

1.1 什么是深度学习 1

1.2 主要核心模型 3

1.2.1 卷积神经网络 3

1.2.2 循环神经网络 4

1.2.3 注意力机制 4

1.2.4 深度生成模型 5

1.2.5 小结 6

1.3 研究和应用领域 6

1.3.1 计算机视觉 6

1.3.2 语音技术 7

1.3.3 自然语言处理 7

1.3.4 多模态融合 8

1.3.5 小结 9

1.4 使用的技术栈 9

1.4.1 编程语言 9

1.4.2 深度学习框架 9

1.4.3 数据集 10

1.4.4 代码编辑器 10

1.4.5 项目IDE 10

1.4.6 小结 10

第 2章 *要的数学预备知识 11

2.1 线性代数 12

2.1.1 学人工智能为什么要学线性

代数 12

2.1.2 线性代数名字的由来 13

2.1.3 线性代数的本质作用 13

2.1.4 学线性代数为何总强调几何

意义 13

2.1.5 标量 14

2.1.6 向量 14

2.1.7 矩阵 17

2.1.8 张量 19

2.1.9 小结 20

2.2 微积分 20

2.2.1 极限 21

2.2.2 导数 21

2.2.3 微分 23

2.2.4 偏导数 23

2.2.5 梯度 24

2.2.6 链式法则 24

2.2.7 小结 25

2.3 概率统计 25

2.3.1 什么是概率 25

2.3.2 概率和统计 28

2.3.3 贝叶斯定理 30

2.3.4 *似然估计 31

2.3.5 小结 31

第3章 环境安装和工具使用 33

3.1 配置深度学习环境 34

3.1.1 CUDA简介 34

3.1.2 显卡驱动 34

3.1.3 安装CUDA 35

3.1.4 安装Anaconda 37

3.1.5 小结 39

3.2 conda实用命令 39

3.2.1 Anaconda 图形化界面介绍 39

3.2.2 conda的命令行操作 41

3.2.3 小结 43

3.3 Jupyter Notebook快速上手 44

3.3.1 Jupyter Notebook的安装与

运行 45

3.3.2 常用配置项 47

3.3.3 快捷键 48

3.3.4 Markdown语法 49

3.3.5 小结 50

3.4 安装深度学习框架PyTorch 50

3.4.1 PyTorch、CUDA与

NVIDIA 50

3.4.2 安装PyTorch 50

3.4.3 验证安装是否成功 51

3.4.4 小结 52

第4章 深度神经网络:误差倒查

分解 53

4.1 神经网络原理 53

4.1.1 神经元模型 53

4.1.2 神经网络结构 54

4.1.3 损失函数 57

4.1.4 反向传播 58

4.1.5 小结 59

4.2 多层感知机 59

4.2.1 线性模型的局限 60

4.2.2 多层感知机模型 61

4.2.3 *函数 61

4.2.4 小结 66

4.3 前向传播和反向传播 67

4.3.1 前向传播 67

4.3.2 反向传播 68

4.3.3 小结 70

4.4 多层感知机代码实现 70

4.4.1 搭建神经网络的步骤 71

4.4.2 代码实现 71

4.4.3 小结 76

4.5 回归问题 76

4.5.1 一元线性回归 77

4.5.2 多元线性回归 78

4.5.3 多项式回归 79

4.5.4 简单理解梯度下降 80

4.5.5 代码实现 80

4.5.6 小结 84

4.6 分类问题 84

4.6.1 多分类问题的数学表示 85

4.6.2 Softmax回归 86

4.6.3 对数损失函数 86

4.6.4 交叉熵损失函数 87

4.6.5 代码实现 87

4.6.6 小结 90

第5章 常见挑战及对策:一切为了

泛化能力 91

5.1 训练问题分析 91

5.1.1 模型架构设计 91

5.1.2 过拟合与欠拟合 92

5.1.3 代码实现 94

5.1.4 小结 99

5.2 过拟合欠拟合应对策略 99

5.2.1 数据集选择 99

5.2.2 模型选择 100

5.2.3 训练策略选择 101

5.2.4 小结 102

5.3 正则化 102

5.3.1 正则化定义 103

5.3.2 L1正则化 103

5.3.3 L2正则化 104

5.3.4 范数惩罚 105

5.3.5 权重衰减 105

5.3.6 小结 106

5.4 Dropout方法及代码实现 106

5.4.1 基本原理 106

5.4.2 直观解释 107

5.4.3 优缺点分析 109

5.4.4 代码实现 109

5.4.5 小结 112

5.5 梯度消失和梯度爆炸 112

5.5.1 根源分析 113

5.5.2 梯度消失 114

5.5.3 梯度爆炸 114

5.5.4 解决办法 115

5.5.5 小结 117

5.6 模型文件的读写 117

5.6.1 张量的保存和加载 117

5.6.2 模型参数的保存和加载 118

5.6.3 小结 119

第6章 梯度下降算法及变体:*

求解模型参数 120

6.1 为什么要学*化 120

6.1.1 深度学习的*化 120

6.1.2 训练误差和泛化误差 121

6.1.3 常见的优化挑战 123

6.1.4 小结 125

6.2 损失函数及其性质 126

6.2.1 起源和重要性 126

6.2.2 *似然估计 126

6.2.3 *后验 128

6.2.4 贝叶斯估计 129

6.2.5 损失函数的性质 129

6.2.6 小结 133

6.3 梯度下降算法 133

6.3.1 搜索逼近策略 134

6.3.2 梯度 134

6.3.3 偏导数链式法则 135

6.3.4 学习率 136

6.3.5 梯度下降算法 136

6.3.6 小结 137

6.4 梯度下降算法的各种变体 137

6.4.1 加速版改进:随机梯度

下降法 138

6.4.2 折中版改进:小批量随机梯度

下降法 139

6.4.3 一阶动量改进版:动量法 140

6.4.4 二阶动量改进版:AdaGrad

算法 142

6.4.5 自动调整学习率:RMSProp和

AdaDelta算法 144

6.4.6 自适应动量:Adam算法 145

6.4.7 算法大串联及讨论 145

6.4.8 小结 147

6.5 梯度下降算法代码实现 147

6.5.1 梯度下降过程 147

6.5.2 不同优化器效果对比 151

6.5.3 小结 155

6.6 学习率调节器 155

6.6.1 简介 155

6.6.2 常见的学习率调节器 156

6.6.3 代码实现 157

6.6.4 模型训练对比 158

6.6.5 常见学习率调节器的实现 160

6.6.6 小结 161

第7章 基础卷积神经网络:图像处理

利器 162

7.1 为什么要用卷积神经网络 162

7.1.1 全连接层的问题 162

7.1.2 多层感知机的局限 163

7.1.3 解决思路 164

7.1.4 小结 164

7.2 图像卷积 165

7.2.1 卷积 165

7.2.2 图像卷积 166

7.2.3 互相关运算 167

7.2.4 小结 168

7.3 卷积层 168

7.3.1 网络结构 169

7.3.2 感受野 169

7.3.3 与全连接层的区别 170

7.3.4 小结 172

7.4 卷积层常见操作 172

7.4.1 填充 172

7.4.2 步长 173

7.4.3 卷积常见参数关系 173

7.4.4 多通道卷积 174

7.4.5 分组卷积 175

7.4.6 小结 176

7.5 池化层 176

7.5.1 卷积神经网络典型结构 177

7.5.2 *池化和平均池化 177

7.5.3 池化层特点 178

7.5.4 小结 179

7.6 卷积神经网络代码实现 179

7.6.1 LeNet简介 179

7.6.2 代码实现 180

7.6.3 模型训练 182

7.6.4 小结 184

第8章 基础循环神经网络:为序列

数据而生 185

8.1 序列建模 185

8.1.1 序列数据 185

8.1.2 序列模型 187

8.1.3 小结 188

8.2 文本数据预处理 189

8.2.1 预处理流程 189

8.2.2 去除噪声 189

8.2.3 分词 190

8.2.4 去除停用词 190

8.2.5 标准化 191

8.2.6 词表 191

8.2.7 特征提取 191

8.2.8 小结 193

8.3 循环神经网络 194

8.3.1 核心思想 194

8.3.2 展开计算图 194

8.3.3 RNN结构 195

8.3.4 训练模式 196

8.3.5 小结 197

8.4 RNN的反向传播 197

8.4.1 沿时间反向传播 197

8.4.2 参数梯度 198

8.4.3 小结 199

8.5 时间序列数据预测 199

8.5.1 数据集准备 200

8.5.2 构建模型 202

8.5.3 小结 207

8.6 编解码器思想及Seq2Seq模型 208

8.6.1 编解码器思想 208

8.6.2 序列到序列学习 209

8.6.3 编码器 210

8.6.4 解码器 210

8.6.5 模型训练 211

8.6.6 束搜索算法 211

8.6.7 小结 214

8.7 Seq2Seq模型代码实现 214

8.7.1 模型架构 214

8.7.2 Seq2Seq模型简单实现 215

8.7.3 小结 222

第9章 注意力神经网络:赋予模型

认知能力 223

9.1 注意力机制的原理 224

9.1.1 生物学中的注意力 224

9.1.2 深度学习中的注意力机制 225

9.1.3 编解码器思想和注意力机制的

结合 225

9.1.4 注意力的计算 228

9.1.5 全局注意力、局部注意力和

自注意力 230

9.1.6 注意力机制与Transformer 231

9.1.7 注意力机制的应用 231

9.1.8 小结 232

9.2 复杂注意力机制 233

9.2.1 *注意力机制计算的

局限性 233

9.2.2 键值对注意力 234

9.2.3 多头注意力 235

9.2.4 自注意力 236

9.2.5 小结 238

9.3 注意力池化及代码实现 239

9.3.1 注意力可视化 239

9.3.2 注意力池化 241

9.3.3 小结 246

9.4 Transformer模型 246

9.4.1 模型结构 246

9.4.2 编码器结构 247

9.4.3 多头自注意力层 248

9.4.4 位置嵌入 249

9.4.5 残差结构 250

9.4.6 解码器 251

9.4.7 编解码器的协同工作 252

9.4.8 线性层和Softmax层 253

9.4.9 优缺点 254

9.4.10 小结 254

9.5 Transformer模型的代码实现 255

9.5.1 任务数据 255

9.5.2 Transformer模型 256

9.5.3 小结 264

- 人民邮电出版社有限公司 (微信公众号认证)

- 人民邮电出版社微店,为您提供最全面,最专业的一站式购书服务

- 扫描二维码,访问我们的微信店铺

- 随时随地的购物、客服咨询、查询订单和物流...