商品详情

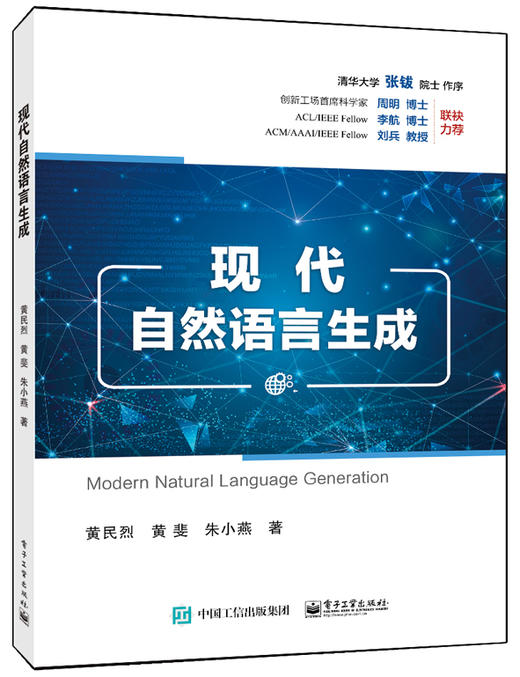

书名:现代自然语言生成

定价:79.0

ISBN:9787121402494

作者:黄民烈,黄斐,朱小燕

版次:第1版

出版时间:2021-01

内容提要:

本书总结了以神经网络为代表的现代自然语言生成的基本思想、模型和框架。本书共12 章,首先介绍了自然语言生成的研究背景、从统计语言模型到神经网络语言建模的过程,以及自然语言建模的思想与技术演化过程;其次从基础模型角度介绍了基于循环神经网络、基于Transformer 的语言生成模型,从优化方法角度介绍了基于变分自编码器、基于生成式对抗网络的语言生成模型,从生成方式角度介绍了非自回归语言生成的基本模型和框架;然后介绍了融合规划的自然语言生成、融合知识的自然语言生成、常见的自然语言生成任务和数据资源,以及自然语言生成的评价方法;*后总结了本书的写作思路及对自然语言生成领域未来发展趋势的展望。 本书可作为高等院校计算机科学与技术、人工智能、大数据等相关专业高年级本科生、研究生相关课程的教材,也适合从事自然语言处理研究、应用实践的科研人员和工程技术人员参考。

作者简介:

黄民烈,博士,清华大学计算机科学与技术系长聘副教授。主要研究兴趣包括人工智能、自然语言处理,尤其是对话系统、语言生成。曾获中国人工智能学会吴文俊人工智能科技进步奖一等奖(排名**)、中文信息学会汉王青年创新奖,多次在国际主流会议获得*佳或杰出论文奖。研发对话系统平台ConvLab和ConvLab-2,获得NTCIR 2017年组织的短文本对话生成评测冠军。担任神经领域**期刊TNNLS(SCI一区,影响因子>11)编委,自然语言处理领域**期刊TACL执行编辑,多次担任自然语言处理**会议ACL、EMNLP的领域主席或资深领域主席。

目录:

第1 章自然语言生成的研究背景. . . . . . . 1

1.1 自然语言生成的背景概述. . . . . . . 1

1.2 基本定义与研究范畴. . . . . . . . . . . .2

1.3 自然语言生成与自然语言理解. . .3

1.4 传统的模块化生成框架. . . . . . . . . 4

1.5 端到端的自然语言生成框架. . . . . 7

1.6 典型的自然语言生成任务. . . . . . . 9

1.7 自然语言生成的可控性. . . . . . . . 12

1.8 本书结构. . . . . . . . . . . . . . . . . . . . . . 14

第2 章从统计语言模型到神经网络语言建模. . . . . . . . . . . . . . . . . . . . . . 15

2.1 统计语言模型. . . . . . . . . . . . . . . . . 15

2.1.1 基本原理. . . . . . . . . . . . . . . . . . 15

2.1.2 平滑技术. . . . . . . . . . . . . . . . . . 17

2.1.3 语言模型评价. . . . . . . . . . . . . . 19

2.1.4 统计语言模型的缺点. . . . . . . . 20

2.2 神经网络语言模型. . . . . . . . . . . . . 21

2.2.1 前馈神经网络语言模型. . . . . . 21

2.2.2 基于循环神经网络的神经语言模型. . . . . . . . . . . . . . 24

2.2.3 基于Transformer 的神经语言模型. . . . . . . . . . . . . . 24

2.3 静态词向量模型. . . . . . . . . . . . . . . 26

2.3.1 分布假设与分布式表示. . . . . . 26

2.3.2 词向量模型CBOW 和Skip-gram. . . . . . . . . . . . . . . . .27

2.3.3 词向量模型训练优化:负采样. . . . . . . . . . . . . . . . . . . .30

2.3.4 词向量模型训练优化:层次化softmax . . . . . . . . . . . . 31

2.3.5 静态词向量的缺陷. . . . . . . . . . 32

2.4 语境化语言表示模型. . . . . . . . . . 33

2.4.1 ELMo . . . . . . . . . . . . . . . . . . . . 34

2.4.2 BERT . . . . . . . . . . . . . . . . . . . . 36

2.4.3 XLNet. . . . . . . . . . . . . . . . . . . .38

2.5 本章小结. . . . . . . . . . . . . . . . . . . . . . 39

第3 章基于RNN 的语言生成模型. . .41

3.1 RNN 的基本原理. . . . . . . . . . . . . . 41

3.2 RNN 的训练算法. . . . . . . . . . . . . . 42

3.3 长短期记忆神经网络与门控循环单元. . . . . . . . . . . . . . . . . 45

3.4 RNN 的架构设计. . . . . . . . . . . . . . 47

3.4.1 多层RNN . . . . . . . . . . . . . . . . 47

3.4.2 双向RNN . . . . . . . . . . . . . . . . 48

3.5 基于RNN 的语言模型. . . . . . . . 48

3.5.1 模型结构. . . . . . . . . . . . . . . . . . 49

3.5.2 主要问题. . . . . . . . . . . . . . . . . . 50

3.5.3 模型改进. . . . . . . . . . . . . . . . . . 51

3.6 序列到序列模型. . . . . . . . . . . . . . . 52

3.6.1 基本原理. . . . . . . . . . . . . . . . . . 52

3.6.2 模型结构. . . . . . . . . . . . . . . . . . 53

3.6.3 注意力机制. . . . . . . . . . . . . . . . 54

3.7 解码器的解码方法. . . . . . . . . . . . . 57

3.7.1 基于搜索的解码方法. . . . . . . . 59

3.7.2 基于采样的解码方法. . . . . . . . 61

3.8 序列到序列模型存在的问题. . . .64

3.9 本章小结. . . . . . . . . . . . . . . . . . . . . . 65

第4 章基于Transformer 的语言生成模型. . . . . . . . . . . . . . . . . 66

4.1 Transformer 模型的基本原理. . . . . . . . . . . . . . . . . . . . . . . . . . 66

4.1.1 多头注意力机制. . . . . . . . . . . . 66

4.1.2 Transformer 基本单元. . . . . . 69

4.2 基于Transformer 的编码器—解码器结构. . . . . . . . . . 71

4.2.1 基本原理. . . . . . . . . . . . . . . . . . 71

4.2.2 位置编码模块. . . . . . . . . . . . . . 73

4.2.3 Transformer 编码器. . . . . . . . 74

4.2.4 Transformer 解码器. . . . . . . . 74

4.3 Transformer 模型与RNN 模型的比较. . . . . . . . . . . . . . 77

4.4 Transformer 模型问题与解决方案. . . . . . . . . . . . . . . . . . . . . . 79

4.4.1 长距离依赖问题. . . . . . . . . . . . 79

4.4.2 运算复杂度问题. . . . . . . . . . . . 81

4.5 基于Transformer 的预训练语言生成模型. . . . . . . . . . . . . . . . . . . . . . 85

4.5.1 GPT 模型. . . . . . . . . . . . . . . . .86

4.5.2 GPT-2 和GPT-3 . . . . . . . . . . 88

4.5.3 GPT 模型的扩展. . . . . . . . . . . 90

4.6 本章小结. . . . . . . . . . . . . . . . . . . . . . 92

第5 章基于变分自编码器的语言生成模型. . . . . . . . . . . . . . . . . 93

5.1 自编码器. . . . . . . . . . . . . . . . . . . . . . 93

5.2 变分自编码器. . . . . . . . . . . . . . . . . 94

5.3 条件变分自编码器. . . . . . . . . . . . . 98

5.4 解码器设计. . . . . . . . . . . . . . . . . . 100

5.5 变分自编码器在语言生成

任务上的应用实例. . . . . . . . . . . .102

5.5.1 含类别约束的条件变分自编码器模型. . . . . . . . . . . . . 102

5.5.2 含隐变量序列的条件变分自编码器模型. . . . . . . . . . . . . 104

5.6 主要问题及解决方案. . . . . . . . . 107

5.6.1 隐变量消失. . . . . . . . . . . . . . .107

5.6.2 可解释性增强. . . . . . . . . . . . .109

5.7 本章小结. . . . . . . . . . . . . . . . . . . . . 111

第6 章基于生成式对抗网络的语言生成模型. . . . . . . . . . . . . . . . 113

6.1 生成式对抗网络的背景. . . . . . . 113

6.2 生成式对抗网络的基本原理. . .115

6.3 生成式对抗网络的基本结构. . .118

6.4 生成式对抗网络的优化问题. . .120

6.4.1 使用强化学习方法训练生成式对抗网络. . . . . . . . . . . . . . . . .120

6.4.2 使用近似方法训练生成式对抗网络. . . . . . . . . . . . . . . . .123

6.5 生成式对抗模型在文本与图像中的区别. . . . . . . . . . . . . . . . 126

6.6 生成式对抗网络的应用. . . . . . . 128

6.6.1 对话生成. . . . . . . . . . . . . . . . .128

6.6.2 无监督的风格迁移. . . . . . . . . 129

6.7 本章小结. . . . . . . . . . . . . . . . . . . . . 130

第7 章非自回归语言生成. . . . . . . . . . . 131

7.1 基本原理. . . . . . . . . . . . . . . . . . . . . 131

7.1.1 适用场景的问题定义. . . . . . . 131

7.1.2 自回归模型和非自回归模型. . . . . . . . . . . . . . . . . . . . 132

7.1.3 模型结构. . . . . . . . . . . . . . . . .132

7.2 非自回归模型的挑战. . . . . . . . . 136

7.2.1 一对多问题. . . . . . . . . . . . . . .136

7.2.2 内部依赖问题. . . . . . . . . . . . .137

7.3 非自回归模型的改进. . . . . . . . . 138

7.3.1 网络结构的改进. . . . . . . . . . . 138

7.3.2 模型理论的改进. . . . . . . . . . . 139

7.3.3 后处理的方法. . . . . . . . . . . . .142

7.3.4 半自回归方法. . . . . . . . . . . . .143

7.4 应用与拓展. . . . . . . . . . . . . . . . . . 144

7.5 本章小结. . . . . . . . . . . . . . . . . . . . . 145

第8 章融合规划的自然语言生成. . . . .146

8.1 数据到文本生成任务中的规划. . . . . . . . . . . . . . . . . . . . . . . . . 147

8.1.1 数据到文本生成任务的定义. . . . . . . . . . . . . . . . . . . . 147

8.1.2 传统的模块化方法. . . . . . . . . 149

8.1.3 神经网络方法. . . . . . . . . . . . .150

8.2 故事生成任务中的规划. . . . . . . 158

8.2.1 故事生成任务的定义. . . . . . . 158

8.2.2 传统方法. . . . . . . . . . . . . . . . .159

8.2.3 神经网络方法. . . . . . . . . . . . .160

8.3 本章小结. . . . . . . . . . . . . . . . . . . . . 163

第9 章融合知识的自然语言生成. . . . .164

9.1 引入知识的动机. . . . . . . . . . . . . . 164

9.2 引入知识面临的挑战. . . . . . . . . 165

9.3 知识的编码与表示. . . . . . . . . . . .166

9.3.1 结构化知识表示. . . . . . . . . . . 167

9.3.2 非结构化知识表示. . . . . . . . . 170

9.4 融合知识的解码方法. . . . . . . . . 172

9.4.1 拷贝网络. . . . . . . . . . . . . . . . .172

9.4.2 生成式预训练. . . . . . . . . . . . .174

9.5 应用实例. . . . . . . . . . . . . . . . . . . . . 175

9.5.1 基于多跳常识推理的语言生成. . . . . . . . . . . . . . . . .175

9.5.2 故事生成. . . . . . . . . . . . . . . . .180

9.6 发展趋势. . . . . . . . . . . . . . . . . . . . . 185

9.6.1 语言模型与知识的融合. . . . . 185

9.6.2 预训练模型与知识的融合. . . 186

9.7 本章小结. . . . . . . . . . . . . . . . . . . . . 189

第10 章常见的自然语言生成任务和数据资源. . . . . . . . . . . . . . . . . . . 190

10.1 机器翻译. . . . . . . . . . . . . . . . . . . .190

10.1.1 常规机器翻译. . . . . . . . . . . .190

10.1.2 低资源机器翻译. . . . . . . . . . 191

10.1.3 无监督机器翻译. . . . . . . . . . 192

10.2 生成式文本摘要. . . . . . . . . . . . . 192

10.2.1 短文本摘要. . . . . . . . . . . . . .192

10.2.2 长文本摘要. . . . . . . . . . . . . .193

10.2.3 多文档摘要. . . . . . . . . . . . . .193

10.2.4 跨语言文本摘要. . . . . . . . . . 193

10.2.5 对话摘要. . . . . . . . . . . . . . . .194

10.2.6 细粒度文本摘要. . . . . . . . . . 195

10.3 意义到文本生成. . . . . . . . . . . . . 195

10.3.1 抽象语义表示到文本生成. . . . . . . . . . . . . . . .195

10.3.2 逻辑表达式到文本生成. . . . 197

10.4 数据到文本生成. . . . . . . . . . . . . 197

10.5 故事生成. . . . . . . . . . . . . . . . . . . .200

10.5.1 条件故事生成. . . . . . . . . . . .200

10.5.2 故事结局生成. . . . . . . . . . . .201

10.5.3 故事补全. . . . . . . . . . . . . . . .202

10.5.4 反事实故事生成. . . . . . . . . . 202

10.6 对话生成. . . . . . . . . . . . . . . . . . . .203

10.6.1 常规对话生成. . . . . . . . . . . .203

10.6.2 知识导引的对话生成. . . . . . 204

10.6.3 个性化对话生成. . . . . . . . . . 206

10.6.4 情感对话生成. . . . . . . . . . . .207

10.7 多模态语言生成. . . . . . . . . . . . . 208

10.7.1 图像描述生成. . . . . . . . . . . .208

10.7.2 视频描述生成. . . . . . . . . . . .208

10.7.3 视觉故事生成. . . . . . . . . . . .210

10.7.4 视觉对话. . . . . . . . . . . . . . . .210

10.8 无约束语言生成. . . . . . . . . . . . . 211

10.9 本章小结. . . . . . . . . . . . . . . . . . . .213

第11 章自然语言生成的评价方法. . . 214

11.1 语言生成评价的角度. . . . . . . . 215

11.2 人工评价. . . . . . . . . . . . . . . . . . . .216

11.2.1 人工评价的分类. . . . . . . . . . 216

11.2.2 标注一致性. . . . . . . . . . . . . .217

11.2.3 人工评价的问题与挑战. . . . 219

11.3 自动评价. . . . . . . . . . . . . . . . . . . .220

11.3.1 无需学习的自动评价方法. . . . . . . . . . . . . . . .222

11.3.2 可学习的自动评价方法. . . . 228

11.4 自动评价与人工评价的结合. . . . . . . . . . . . . . . . . . . . . . . . 236

11.5 自动评价与人工评价的统计相关性. . . . . . . . . . . . . . . . . 238

11.5.1 Pearson 相关系数. . . . . . . . 238

11.5.2 Spearman 相关系数. . . . . . 239

11.5.3 Kendall 相关系数. . . . . . . . 239

11.5.4 相关系数的显著性. . . . . . . . 240

11.6 本章小结. . . . . . . . . . . . . . . . . . . .240

第12 章自然语言生成的趋势展望. . . 242

12.1 现状分析. . . . . . . . . . . . . . . . . . . .242

12.2 趋势展望. . . . . . . . . . . . . . . . . . . .245

参考文献. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 249

定价:79.0

ISBN:9787121402494

作者:黄民烈,黄斐,朱小燕

版次:第1版

出版时间:2021-01

内容提要:

本书总结了以神经网络为代表的现代自然语言生成的基本思想、模型和框架。本书共12 章,首先介绍了自然语言生成的研究背景、从统计语言模型到神经网络语言建模的过程,以及自然语言建模的思想与技术演化过程;其次从基础模型角度介绍了基于循环神经网络、基于Transformer 的语言生成模型,从优化方法角度介绍了基于变分自编码器、基于生成式对抗网络的语言生成模型,从生成方式角度介绍了非自回归语言生成的基本模型和框架;然后介绍了融合规划的自然语言生成、融合知识的自然语言生成、常见的自然语言生成任务和数据资源,以及自然语言生成的评价方法;*后总结了本书的写作思路及对自然语言生成领域未来发展趋势的展望。 本书可作为高等院校计算机科学与技术、人工智能、大数据等相关专业高年级本科生、研究生相关课程的教材,也适合从事自然语言处理研究、应用实践的科研人员和工程技术人员参考。

作者简介:

黄民烈,博士,清华大学计算机科学与技术系长聘副教授。主要研究兴趣包括人工智能、自然语言处理,尤其是对话系统、语言生成。曾获中国人工智能学会吴文俊人工智能科技进步奖一等奖(排名**)、中文信息学会汉王青年创新奖,多次在国际主流会议获得*佳或杰出论文奖。研发对话系统平台ConvLab和ConvLab-2,获得NTCIR 2017年组织的短文本对话生成评测冠军。担任神经领域**期刊TNNLS(SCI一区,影响因子>11)编委,自然语言处理领域**期刊TACL执行编辑,多次担任自然语言处理**会议ACL、EMNLP的领域主席或资深领域主席。

目录:

第1 章自然语言生成的研究背景. . . . . . . 1

1.1 自然语言生成的背景概述. . . . . . . 1

1.2 基本定义与研究范畴. . . . . . . . . . . .2

1.3 自然语言生成与自然语言理解. . .3

1.4 传统的模块化生成框架. . . . . . . . . 4

1.5 端到端的自然语言生成框架. . . . . 7

1.6 典型的自然语言生成任务. . . . . . . 9

1.7 自然语言生成的可控性. . . . . . . . 12

1.8 本书结构. . . . . . . . . . . . . . . . . . . . . . 14

第2 章从统计语言模型到神经网络语言建模. . . . . . . . . . . . . . . . . . . . . . 15

2.1 统计语言模型. . . . . . . . . . . . . . . . . 15

2.1.1 基本原理. . . . . . . . . . . . . . . . . . 15

2.1.2 平滑技术. . . . . . . . . . . . . . . . . . 17

2.1.3 语言模型评价. . . . . . . . . . . . . . 19

2.1.4 统计语言模型的缺点. . . . . . . . 20

2.2 神经网络语言模型. . . . . . . . . . . . . 21

2.2.1 前馈神经网络语言模型. . . . . . 21

2.2.2 基于循环神经网络的神经语言模型. . . . . . . . . . . . . . 24

2.2.3 基于Transformer 的神经语言模型. . . . . . . . . . . . . . 24

2.3 静态词向量模型. . . . . . . . . . . . . . . 26

2.3.1 分布假设与分布式表示. . . . . . 26

2.3.2 词向量模型CBOW 和Skip-gram. . . . . . . . . . . . . . . . .27

2.3.3 词向量模型训练优化:负采样. . . . . . . . . . . . . . . . . . . .30

2.3.4 词向量模型训练优化:层次化softmax . . . . . . . . . . . . 31

2.3.5 静态词向量的缺陷. . . . . . . . . . 32

2.4 语境化语言表示模型. . . . . . . . . . 33

2.4.1 ELMo . . . . . . . . . . . . . . . . . . . . 34

2.4.2 BERT . . . . . . . . . . . . . . . . . . . . 36

2.4.3 XLNet. . . . . . . . . . . . . . . . . . . .38

2.5 本章小结. . . . . . . . . . . . . . . . . . . . . . 39

第3 章基于RNN 的语言生成模型. . .41

3.1 RNN 的基本原理. . . . . . . . . . . . . . 41

3.2 RNN 的训练算法. . . . . . . . . . . . . . 42

3.3 长短期记忆神经网络与门控循环单元. . . . . . . . . . . . . . . . . 45

3.4 RNN 的架构设计. . . . . . . . . . . . . . 47

3.4.1 多层RNN . . . . . . . . . . . . . . . . 47

3.4.2 双向RNN . . . . . . . . . . . . . . . . 48

3.5 基于RNN 的语言模型. . . . . . . . 48

3.5.1 模型结构. . . . . . . . . . . . . . . . . . 49

3.5.2 主要问题. . . . . . . . . . . . . . . . . . 50

3.5.3 模型改进. . . . . . . . . . . . . . . . . . 51

3.6 序列到序列模型. . . . . . . . . . . . . . . 52

3.6.1 基本原理. . . . . . . . . . . . . . . . . . 52

3.6.2 模型结构. . . . . . . . . . . . . . . . . . 53

3.6.3 注意力机制. . . . . . . . . . . . . . . . 54

3.7 解码器的解码方法. . . . . . . . . . . . . 57

3.7.1 基于搜索的解码方法. . . . . . . . 59

3.7.2 基于采样的解码方法. . . . . . . . 61

3.8 序列到序列模型存在的问题. . . .64

3.9 本章小结. . . . . . . . . . . . . . . . . . . . . . 65

第4 章基于Transformer 的语言生成模型. . . . . . . . . . . . . . . . . 66

4.1 Transformer 模型的基本原理. . . . . . . . . . . . . . . . . . . . . . . . . . 66

4.1.1 多头注意力机制. . . . . . . . . . . . 66

4.1.2 Transformer 基本单元. . . . . . 69

4.2 基于Transformer 的编码器—解码器结构. . . . . . . . . . 71

4.2.1 基本原理. . . . . . . . . . . . . . . . . . 71

4.2.2 位置编码模块. . . . . . . . . . . . . . 73

4.2.3 Transformer 编码器. . . . . . . . 74

4.2.4 Transformer 解码器. . . . . . . . 74

4.3 Transformer 模型与RNN 模型的比较. . . . . . . . . . . . . . 77

4.4 Transformer 模型问题与解决方案. . . . . . . . . . . . . . . . . . . . . . 79

4.4.1 长距离依赖问题. . . . . . . . . . . . 79

4.4.2 运算复杂度问题. . . . . . . . . . . . 81

4.5 基于Transformer 的预训练语言生成模型. . . . . . . . . . . . . . . . . . . . . . 85

4.5.1 GPT 模型. . . . . . . . . . . . . . . . .86

4.5.2 GPT-2 和GPT-3 . . . . . . . . . . 88

4.5.3 GPT 模型的扩展. . . . . . . . . . . 90

4.6 本章小结. . . . . . . . . . . . . . . . . . . . . . 92

第5 章基于变分自编码器的语言生成模型. . . . . . . . . . . . . . . . . 93

5.1 自编码器. . . . . . . . . . . . . . . . . . . . . . 93

5.2 变分自编码器. . . . . . . . . . . . . . . . . 94

5.3 条件变分自编码器. . . . . . . . . . . . . 98

5.4 解码器设计. . . . . . . . . . . . . . . . . . 100

5.5 变分自编码器在语言生成

任务上的应用实例. . . . . . . . . . . .102

5.5.1 含类别约束的条件变分自编码器模型. . . . . . . . . . . . . 102

5.5.2 含隐变量序列的条件变分自编码器模型. . . . . . . . . . . . . 104

5.6 主要问题及解决方案. . . . . . . . . 107

5.6.1 隐变量消失. . . . . . . . . . . . . . .107

5.6.2 可解释性增强. . . . . . . . . . . . .109

5.7 本章小结. . . . . . . . . . . . . . . . . . . . . 111

第6 章基于生成式对抗网络的语言生成模型. . . . . . . . . . . . . . . . 113

6.1 生成式对抗网络的背景. . . . . . . 113

6.2 生成式对抗网络的基本原理. . .115

6.3 生成式对抗网络的基本结构. . .118

6.4 生成式对抗网络的优化问题. . .120

6.4.1 使用强化学习方法训练生成式对抗网络. . . . . . . . . . . . . . . . .120

6.4.2 使用近似方法训练生成式对抗网络. . . . . . . . . . . . . . . . .123

6.5 生成式对抗模型在文本与图像中的区别. . . . . . . . . . . . . . . . 126

6.6 生成式对抗网络的应用. . . . . . . 128

6.6.1 对话生成. . . . . . . . . . . . . . . . .128

6.6.2 无监督的风格迁移. . . . . . . . . 129

6.7 本章小结. . . . . . . . . . . . . . . . . . . . . 130

第7 章非自回归语言生成. . . . . . . . . . . 131

7.1 基本原理. . . . . . . . . . . . . . . . . . . . . 131

7.1.1 适用场景的问题定义. . . . . . . 131

7.1.2 自回归模型和非自回归模型. . . . . . . . . . . . . . . . . . . . 132

7.1.3 模型结构. . . . . . . . . . . . . . . . .132

7.2 非自回归模型的挑战. . . . . . . . . 136

7.2.1 一对多问题. . . . . . . . . . . . . . .136

7.2.2 内部依赖问题. . . . . . . . . . . . .137

7.3 非自回归模型的改进. . . . . . . . . 138

7.3.1 网络结构的改进. . . . . . . . . . . 138

7.3.2 模型理论的改进. . . . . . . . . . . 139

7.3.3 后处理的方法. . . . . . . . . . . . .142

7.3.4 半自回归方法. . . . . . . . . . . . .143

7.4 应用与拓展. . . . . . . . . . . . . . . . . . 144

7.5 本章小结. . . . . . . . . . . . . . . . . . . . . 145

第8 章融合规划的自然语言生成. . . . .146

8.1 数据到文本生成任务中的规划. . . . . . . . . . . . . . . . . . . . . . . . . 147

8.1.1 数据到文本生成任务的定义. . . . . . . . . . . . . . . . . . . . 147

8.1.2 传统的模块化方法. . . . . . . . . 149

8.1.3 神经网络方法. . . . . . . . . . . . .150

8.2 故事生成任务中的规划. . . . . . . 158

8.2.1 故事生成任务的定义. . . . . . . 158

8.2.2 传统方法. . . . . . . . . . . . . . . . .159

8.2.3 神经网络方法. . . . . . . . . . . . .160

8.3 本章小结. . . . . . . . . . . . . . . . . . . . . 163

第9 章融合知识的自然语言生成. . . . .164

9.1 引入知识的动机. . . . . . . . . . . . . . 164

9.2 引入知识面临的挑战. . . . . . . . . 165

9.3 知识的编码与表示. . . . . . . . . . . .166

9.3.1 结构化知识表示. . . . . . . . . . . 167

9.3.2 非结构化知识表示. . . . . . . . . 170

9.4 融合知识的解码方法. . . . . . . . . 172

9.4.1 拷贝网络. . . . . . . . . . . . . . . . .172

9.4.2 生成式预训练. . . . . . . . . . . . .174

9.5 应用实例. . . . . . . . . . . . . . . . . . . . . 175

9.5.1 基于多跳常识推理的语言生成. . . . . . . . . . . . . . . . .175

9.5.2 故事生成. . . . . . . . . . . . . . . . .180

9.6 发展趋势. . . . . . . . . . . . . . . . . . . . . 185

9.6.1 语言模型与知识的融合. . . . . 185

9.6.2 预训练模型与知识的融合. . . 186

9.7 本章小结. . . . . . . . . . . . . . . . . . . . . 189

第10 章常见的自然语言生成任务和数据资源. . . . . . . . . . . . . . . . . . . 190

10.1 机器翻译. . . . . . . . . . . . . . . . . . . .190

10.1.1 常规机器翻译. . . . . . . . . . . .190

10.1.2 低资源机器翻译. . . . . . . . . . 191

10.1.3 无监督机器翻译. . . . . . . . . . 192

10.2 生成式文本摘要. . . . . . . . . . . . . 192

10.2.1 短文本摘要. . . . . . . . . . . . . .192

10.2.2 长文本摘要. . . . . . . . . . . . . .193

10.2.3 多文档摘要. . . . . . . . . . . . . .193

10.2.4 跨语言文本摘要. . . . . . . . . . 193

10.2.5 对话摘要. . . . . . . . . . . . . . . .194

10.2.6 细粒度文本摘要. . . . . . . . . . 195

10.3 意义到文本生成. . . . . . . . . . . . . 195

10.3.1 抽象语义表示到文本生成. . . . . . . . . . . . . . . .195

10.3.2 逻辑表达式到文本生成. . . . 197

10.4 数据到文本生成. . . . . . . . . . . . . 197

10.5 故事生成. . . . . . . . . . . . . . . . . . . .200

10.5.1 条件故事生成. . . . . . . . . . . .200

10.5.2 故事结局生成. . . . . . . . . . . .201

10.5.3 故事补全. . . . . . . . . . . . . . . .202

10.5.4 反事实故事生成. . . . . . . . . . 202

10.6 对话生成. . . . . . . . . . . . . . . . . . . .203

10.6.1 常规对话生成. . . . . . . . . . . .203

10.6.2 知识导引的对话生成. . . . . . 204

10.6.3 个性化对话生成. . . . . . . . . . 206

10.6.4 情感对话生成. . . . . . . . . . . .207

10.7 多模态语言生成. . . . . . . . . . . . . 208

10.7.1 图像描述生成. . . . . . . . . . . .208

10.7.2 视频描述生成. . . . . . . . . . . .208

10.7.3 视觉故事生成. . . . . . . . . . . .210

10.7.4 视觉对话. . . . . . . . . . . . . . . .210

10.8 无约束语言生成. . . . . . . . . . . . . 211

10.9 本章小结. . . . . . . . . . . . . . . . . . . .213

第11 章自然语言生成的评价方法. . . 214

11.1 语言生成评价的角度. . . . . . . . 215

11.2 人工评价. . . . . . . . . . . . . . . . . . . .216

11.2.1 人工评价的分类. . . . . . . . . . 216

11.2.2 标注一致性. . . . . . . . . . . . . .217

11.2.3 人工评价的问题与挑战. . . . 219

11.3 自动评价. . . . . . . . . . . . . . . . . . . .220

11.3.1 无需学习的自动评价方法. . . . . . . . . . . . . . . .222

11.3.2 可学习的自动评价方法. . . . 228

11.4 自动评价与人工评价的结合. . . . . . . . . . . . . . . . . . . . . . . . 236

11.5 自动评价与人工评价的统计相关性. . . . . . . . . . . . . . . . . 238

11.5.1 Pearson 相关系数. . . . . . . . 238

11.5.2 Spearman 相关系数. . . . . . 239

11.5.3 Kendall 相关系数. . . . . . . . 239

11.5.4 相关系数的显著性. . . . . . . . 240

11.6 本章小结. . . . . . . . . . . . . . . . . . . .240

第12 章自然语言生成的趋势展望. . . 242

12.1 现状分析. . . . . . . . . . . . . . . . . . . .242

12.2 趋势展望. . . . . . . . . . . . . . . . . . . .245

参考文献. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 249

- 电子工业出版社有限公司

- 电子工业出版社有限公司有赞官方供货商,为客户提供一流的知识产品及服务。

- 扫描二维码,访问我们的微信店铺