动手学自然语言处理 Transformer自然语言处理实战GPT大模型NLP应用人工智能深度学习神经网络理论

¥67.40

| 运费: | ¥ 0.00-20.00 |

商品详情

书名:动手学自然语言处理

定价:89.8

ISBN:9787115636461

作者:屠可伟 王新宇 曲彦儒 俞勇

版次:第1版

出版时间:2024-05

内容提要:

本书介绍自然语言处理的原理和方法及其代码实现,是一本着眼于自然语言处理教学实践的图书。 本书分为3个部分。*部分介绍基础技术,包括文本规范化、文本表示、文本分类、文本聚类。*部分介绍自然语言的序列建模,包括语言模型、序列到序列模型、预训练语言模型、序列标注。第三部分介绍自然语言的结构建模,包括成分句法分析、依存句法分析、语义分析、篇章分析。本书将自然语言处理的理论与实践相结合,提供所介绍方法的代码示例,能够帮助读者掌握理论知识并进行动手实践。 本书适合作为高校自然语言处理课程的教材,也可作为相关行业的研究人员和开发人员的参考资料。

作者简介:

屠可伟,上海科技大学信息科学与技术学院长聘副教授、研究员、博士生导师。研究方向包括自然语言处理、机器学习等,主要研究将符号、统计和神经方法相结合用于语言结构的表示、学习与利用。发表论文100余篇,主要发表在ACL、EMNLP、AAAI 等人工智能领域*会议。担任多个*会议程序委员会委员和领域主席。曾获ACL 2023杰出论文奖,以及SemEval 2022和SemEval 2023*系统论文奖。 王新宇,上海科技大学博士,长期从事自然语言处理研究工作,在ACL、EMNLP、NAACL等*会议上发表论文10余篇,担任ACL、NAACL会议的领域主席以及ACL滚动审查(ACL Rolling Review)执行编辑。曾获得中国中文信息学会*博士学位论文提名、SemEval 2022*系统论文奖等荣誉。 曲彦儒,伊利诺伊大学厄巴纳-香槟分校博士生,长期从事自然语言处理研究工作,在ACL、NAACL、AAAI、ICLR等会议上发表了多篇论文。 俞勇,上海交通大学ACM班创办人,*教学名师,上海交通大学特聘教授。2018年创办伯禹人工智能学院,在上海交通大学ACM班人工智能专业课程体系的基础上,对人工智能课程体系进行创新,致力于培养*的人工智能算法工程师和研究员。

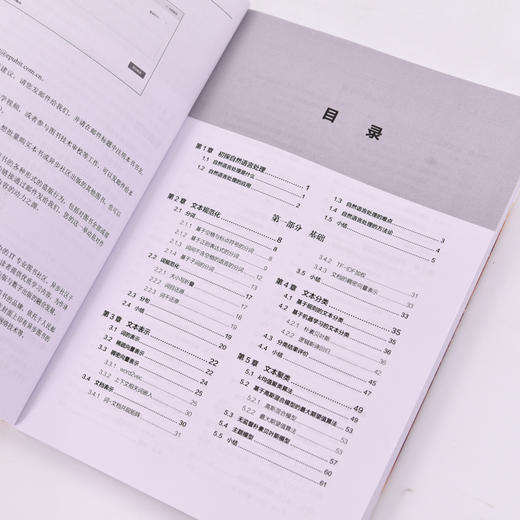

目录:

第 1章 初探自然语言处理 1

1.1 自然语言处理是什么 1

1.2 自然语言处理的应用 2

1.3 自然语言处理的难点 3

1.4 自然语言处理的方法论 4

1.5 小结 5

第 一部分 基础

第 2章 文本规范化 8

2.1 分词 8

2.1.1 基于空格与标点符号的分词 8

2.1.2 基于正则表达式的分词 9

2.1.3 词间不含空格的语言的分词 12

2.1.4 基于子词的分词 13

2.2 词规范化 17

2.2.1 大小写折叠 17

2.2.2 词目还原 18

2.2.3 词干还原 19

2.3 分句 19

2.4 小结 20

第3章 文本表示 22

3.1 词的表示 22

3.2 稀疏向量表示 24

3.3 稠密向量表示 25

3.3.1 word2vec 25

3.3.2 上下文相关词嵌入 30

3.4 文档表示 30

3.4.1 词-文档共现矩阵 31

3.4.2 TF-IDF加权 31

3.4.3 文档的稠密向量表示 33

3.5 小结 33

第4章 文本分类 35

4.1 基于规则的文本分类 35

4.2 基于机器学习的文本分类 36

4.2.1 朴素贝叶斯 36

4.2.2 逻辑斯谛回归 42

4.3 分类结果评价 45

4.4 小结 47

第5章 文本聚类 49

5.1 k均值聚类算法 49

5.2 基于高斯混合模型的*期望值算法 53

5.2.1 高斯混合模型 53

5.2.2 *期望值算法 53

5.3 无监督朴素贝叶斯模型 57

5.4 主题模型 60

5.5 小结 61

*部分 序列

第6章 语言模型 64

6.1 概述 64

6.2 n元语法模型 66

6.3 循环神经网络 67

6.3.1 循环神经网络 67

6.3.2 长短期记忆 73

6.3.3 多层双向循环神经网络 76

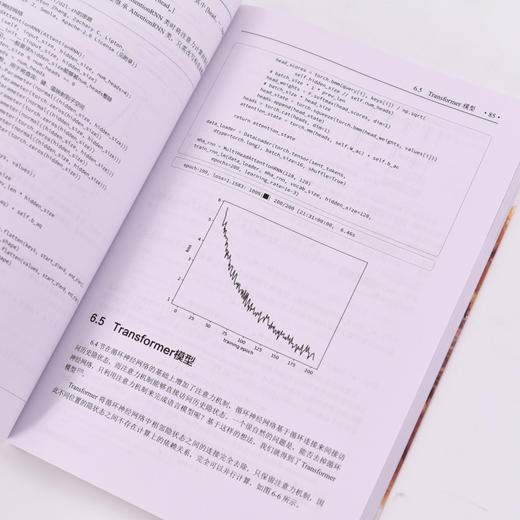

6.4 注意力机制 80

多头注意力 83

6.5 Transformer模型 85

6.6 小结 91

第7章 序列到序列模型 93

7.1 基于神经网络的序列到序列模型 93

7.1.1 循环神经网络 94

7.1.2 注意力机制 96

7.1.3 Transformer 98

7.2 学习 101

7.3 解码 106

7.3.1 贪心解码 106

7.3.2 束搜索解码 107

7.3.3 其他解码问题与解决技巧 110

7.4 指针网络 111

7.5 序列到序列任务的延伸 112

7.6 小结 113

第8章 预训练语言模型 114

8.1 ELMo:基于语言模型的上下文相关词嵌入 114

8.2 BERT:基于Transformer的双向编码器表示 115

8.2.1 掩码语言模型 115

8.2.2 BERT模型 116

8.2.3 预训练 116

8.2.4 微调与提示 117

8.2.5 BERT代码演示 117

8.2.6 BERT模型扩展 121

8.3 GPT:基于Transformer的生成式预训练语言模型 122

8.3.1 GPT模型的历史 122

8.3.2 GPT-2训练演示 123

8.3.3 GPT的使用 125

8.4 基于编码器-解码器的预训练语言模型 128

8.5 基于HuggingFace的预训练语言模型使用 129

8.5.1 文本分类 129

8.5.2 文本生成 130

8.5.3 问答 130

8.5.4 文本摘要 131

8.6 小结 131

第9章 序列标注 133

9.1 序列标注任务 133

9.1.1 词性标注 133

9.1.2 中文分词 134

9.1.3 命名实体识别 134

9.1.4 语义角色标注 135

9.2 隐马尔可夫模型 135

9.2.1 模型 135

9.2.2 解码 136

9.2.3 输入序列的边际概率 137

9.2.4 单个标签的边际概率 138

9.2.5 监督学习 139

9.2.6 无监督学习 139

9.2.7 部分代码实现 141

9.3 条件随机场 146

9.3.1 模型 146

9.3.2 解码 147

9.3.3 监督学习 148

9.3.4 无监督学习 149

9.3.5 部分代码实现 149

9.4 神经序列标注模型 154

9.4.1 神经softmax 154

9.4.2 神经条件随机场 154

9.4.3 代码实现 155

9.5 小结 156

第三部分 结构

第 10章 成分句法分析 160

10.1 成分结构 160

10.2 成分句法分析概述 161

10.2.1 歧义性与打分 161

10.2.2 解码 162

10.2.3 学习 162

10.2.4 评价指标 163

10.3 基于跨度的成分句法分析 163

10.3.1 打分 164

10.3.2 解码 165

10.3.3 学习 170

10.4 基于转移的成分句法分析 173

10.4.1 状态与转移 173

10.4.2 转移的打分 174

10.4.3 解码 175

10.4.4 学习 176

10.5 基于上下文无关文法的成分句法分析 177

10.5.1 上下文无关文法 177

10.5.2 解码和学习 178

10.6 小结 179

第 11章 依存句法分析 181

11.1 依存结构 181

11.1.1 投射性 182

11.1.2 与成分结构的关系 182

11.2 依存句法分析概述 184

11.2.1 打分、解码和学习 184

11.2.2 评价指标 184

11.3 基于图的依存句法分析 185

11.3.1 打分 185

11.3.2 解码 186

11.3.3 Eisner算法 186

11.3.4 MST算法 191

11.3.5 高阶方法 194

11.3.6 监督学习 194

11.4 基于转移的依存句法分析 195

11.4.1 状态与转移 196

11.4.2 打分、解码与学习 196

11.5 小结 198

第 12章 语义分析 200

12.1 显式和隐式的语义表示 200

12.2 词义表示 201

12.2.1 WordNet 201

12.2.2 词义消歧 203

12.3 语义表示 204

12.3.1 专用和通用的语义表示 204

12.3.2 一阶逻辑 205

12.3.3 语义图 205

12.4 语义分析 206

12.4.1 基于句法的语义分析 206

12.4.2 基于神经网络的语义分析 207

12.4.3 弱监督学习 209

12.5 语义角色标注 209

12.5.1 语义角色标注标准 209

12.5.2 语义角色标注方法 211

12.6 信息提取 211

12.7 小结 212

第 13章 篇章分析 213

13.1 篇章 213

13.1.1 连贯性关系 213

13.1.2 篇章结构 214

13.1.3 篇章分析 215

13.2 共指消解 215

13.2.1 提及检测 216

13.2.2 提及聚类 216

13.3 小结 220

总结与展望 221

参考文献 223

中英文术语对照表 228

附 录 234

定价:89.8

ISBN:9787115636461

作者:屠可伟 王新宇 曲彦儒 俞勇

版次:第1版

出版时间:2024-05

内容提要:

本书介绍自然语言处理的原理和方法及其代码实现,是一本着眼于自然语言处理教学实践的图书。 本书分为3个部分。*部分介绍基础技术,包括文本规范化、文本表示、文本分类、文本聚类。*部分介绍自然语言的序列建模,包括语言模型、序列到序列模型、预训练语言模型、序列标注。第三部分介绍自然语言的结构建模,包括成分句法分析、依存句法分析、语义分析、篇章分析。本书将自然语言处理的理论与实践相结合,提供所介绍方法的代码示例,能够帮助读者掌握理论知识并进行动手实践。 本书适合作为高校自然语言处理课程的教材,也可作为相关行业的研究人员和开发人员的参考资料。

作者简介:

屠可伟,上海科技大学信息科学与技术学院长聘副教授、研究员、博士生导师。研究方向包括自然语言处理、机器学习等,主要研究将符号、统计和神经方法相结合用于语言结构的表示、学习与利用。发表论文100余篇,主要发表在ACL、EMNLP、AAAI 等人工智能领域*会议。担任多个*会议程序委员会委员和领域主席。曾获ACL 2023杰出论文奖,以及SemEval 2022和SemEval 2023*系统论文奖。 王新宇,上海科技大学博士,长期从事自然语言处理研究工作,在ACL、EMNLP、NAACL等*会议上发表论文10余篇,担任ACL、NAACL会议的领域主席以及ACL滚动审查(ACL Rolling Review)执行编辑。曾获得中国中文信息学会*博士学位论文提名、SemEval 2022*系统论文奖等荣誉。 曲彦儒,伊利诺伊大学厄巴纳-香槟分校博士生,长期从事自然语言处理研究工作,在ACL、NAACL、AAAI、ICLR等会议上发表了多篇论文。 俞勇,上海交通大学ACM班创办人,*教学名师,上海交通大学特聘教授。2018年创办伯禹人工智能学院,在上海交通大学ACM班人工智能专业课程体系的基础上,对人工智能课程体系进行创新,致力于培养*的人工智能算法工程师和研究员。

目录:

第 1章 初探自然语言处理 1

1.1 自然语言处理是什么 1

1.2 自然语言处理的应用 2

1.3 自然语言处理的难点 3

1.4 自然语言处理的方法论 4

1.5 小结 5

第 一部分 基础

第 2章 文本规范化 8

2.1 分词 8

2.1.1 基于空格与标点符号的分词 8

2.1.2 基于正则表达式的分词 9

2.1.3 词间不含空格的语言的分词 12

2.1.4 基于子词的分词 13

2.2 词规范化 17

2.2.1 大小写折叠 17

2.2.2 词目还原 18

2.2.3 词干还原 19

2.3 分句 19

2.4 小结 20

第3章 文本表示 22

3.1 词的表示 22

3.2 稀疏向量表示 24

3.3 稠密向量表示 25

3.3.1 word2vec 25

3.3.2 上下文相关词嵌入 30

3.4 文档表示 30

3.4.1 词-文档共现矩阵 31

3.4.2 TF-IDF加权 31

3.4.3 文档的稠密向量表示 33

3.5 小结 33

第4章 文本分类 35

4.1 基于规则的文本分类 35

4.2 基于机器学习的文本分类 36

4.2.1 朴素贝叶斯 36

4.2.2 逻辑斯谛回归 42

4.3 分类结果评价 45

4.4 小结 47

第5章 文本聚类 49

5.1 k均值聚类算法 49

5.2 基于高斯混合模型的*期望值算法 53

5.2.1 高斯混合模型 53

5.2.2 *期望值算法 53

5.3 无监督朴素贝叶斯模型 57

5.4 主题模型 60

5.5 小结 61

*部分 序列

第6章 语言模型 64

6.1 概述 64

6.2 n元语法模型 66

6.3 循环神经网络 67

6.3.1 循环神经网络 67

6.3.2 长短期记忆 73

6.3.3 多层双向循环神经网络 76

6.4 注意力机制 80

多头注意力 83

6.5 Transformer模型 85

6.6 小结 91

第7章 序列到序列模型 93

7.1 基于神经网络的序列到序列模型 93

7.1.1 循环神经网络 94

7.1.2 注意力机制 96

7.1.3 Transformer 98

7.2 学习 101

7.3 解码 106

7.3.1 贪心解码 106

7.3.2 束搜索解码 107

7.3.3 其他解码问题与解决技巧 110

7.4 指针网络 111

7.5 序列到序列任务的延伸 112

7.6 小结 113

第8章 预训练语言模型 114

8.1 ELMo:基于语言模型的上下文相关词嵌入 114

8.2 BERT:基于Transformer的双向编码器表示 115

8.2.1 掩码语言模型 115

8.2.2 BERT模型 116

8.2.3 预训练 116

8.2.4 微调与提示 117

8.2.5 BERT代码演示 117

8.2.6 BERT模型扩展 121

8.3 GPT:基于Transformer的生成式预训练语言模型 122

8.3.1 GPT模型的历史 122

8.3.2 GPT-2训练演示 123

8.3.3 GPT的使用 125

8.4 基于编码器-解码器的预训练语言模型 128

8.5 基于HuggingFace的预训练语言模型使用 129

8.5.1 文本分类 129

8.5.2 文本生成 130

8.5.3 问答 130

8.5.4 文本摘要 131

8.6 小结 131

第9章 序列标注 133

9.1 序列标注任务 133

9.1.1 词性标注 133

9.1.2 中文分词 134

9.1.3 命名实体识别 134

9.1.4 语义角色标注 135

9.2 隐马尔可夫模型 135

9.2.1 模型 135

9.2.2 解码 136

9.2.3 输入序列的边际概率 137

9.2.4 单个标签的边际概率 138

9.2.5 监督学习 139

9.2.6 无监督学习 139

9.2.7 部分代码实现 141

9.3 条件随机场 146

9.3.1 模型 146

9.3.2 解码 147

9.3.3 监督学习 148

9.3.4 无监督学习 149

9.3.5 部分代码实现 149

9.4 神经序列标注模型 154

9.4.1 神经softmax 154

9.4.2 神经条件随机场 154

9.4.3 代码实现 155

9.5 小结 156

第三部分 结构

第 10章 成分句法分析 160

10.1 成分结构 160

10.2 成分句法分析概述 161

10.2.1 歧义性与打分 161

10.2.2 解码 162

10.2.3 学习 162

10.2.4 评价指标 163

10.3 基于跨度的成分句法分析 163

10.3.1 打分 164

10.3.2 解码 165

10.3.3 学习 170

10.4 基于转移的成分句法分析 173

10.4.1 状态与转移 173

10.4.2 转移的打分 174

10.4.3 解码 175

10.4.4 学习 176

10.5 基于上下文无关文法的成分句法分析 177

10.5.1 上下文无关文法 177

10.5.2 解码和学习 178

10.6 小结 179

第 11章 依存句法分析 181

11.1 依存结构 181

11.1.1 投射性 182

11.1.2 与成分结构的关系 182

11.2 依存句法分析概述 184

11.2.1 打分、解码和学习 184

11.2.2 评价指标 184

11.3 基于图的依存句法分析 185

11.3.1 打分 185

11.3.2 解码 186

11.3.3 Eisner算法 186

11.3.4 MST算法 191

11.3.5 高阶方法 194

11.3.6 监督学习 194

11.4 基于转移的依存句法分析 195

11.4.1 状态与转移 196

11.4.2 打分、解码与学习 196

11.5 小结 198

第 12章 语义分析 200

12.1 显式和隐式的语义表示 200

12.2 词义表示 201

12.2.1 WordNet 201

12.2.2 词义消歧 203

12.3 语义表示 204

12.3.1 专用和通用的语义表示 204

12.3.2 一阶逻辑 205

12.3.3 语义图 205

12.4 语义分析 206

12.4.1 基于句法的语义分析 206

12.4.2 基于神经网络的语义分析 207

12.4.3 弱监督学习 209

12.5 语义角色标注 209

12.5.1 语义角色标注标准 209

12.5.2 语义角色标注方法 211

12.6 信息提取 211

12.7 小结 212

第 13章 篇章分析 213

13.1 篇章 213

13.1.1 连贯性关系 213

13.1.2 篇章结构 214

13.1.3 篇章分析 215

13.2 共指消解 215

13.2.1 提及检测 216

13.2.2 提及聚类 216

13.3 小结 220

总结与展望 221

参考文献 223

中英文术语对照表 228

附 录 234

- 人民邮电出版社有限公司 (微信公众号认证)

- 人民邮电出版社微店,为您提供最全面,最专业的一站式购书服务

- 扫描二维码,访问我们的微信店铺

- 随时随地的购物、客服咨询、查询订单和物流...